MCP(Model Context Protocol)とは?AI×業務効率化の未来を変える最新標準ガイド

著者: 仲山 隼人 (Hayato Nakayama) 25/03/21 19:31

あなたはAIアシスタントや機械学習モデルを使っていて、こんなことを思ったことはありませんか?

-

「AIがもっと正確な回答をしてくれたらな…」

-

「外部のツールやデータベースと簡単に連携できたら便利なのに…」

-

「カスタマイズしようとしたら、APIやら設定やらで面倒くさい…」

実は、それらの問題を解決するかもしれない技術が MCP(Model Context Protocol) です。まだ聞き慣れないかもしれませんが、今後AIの発展とともに注目されること間違いなしの技術です。

この記事では、 「MCPとは何か?」 から 「具体的にどんなメリットがあるのか?」 まで、初心者にも技術者にも分かりやすく解説します。

目次

-

MCP(Model Context Protocol)とは?

-

なぜMCPが必要なのか?

-

背景と目的

-

従来のAIモデルとの違い

-

ユニバーサルアクセスと柔軟性

-

安全で標準化された接続

-

再利用性と拡張

-

維持管理のたやすさ

-

アーキテクチャ概要

-

通信プロトコル

-

提供される機能種別

-

データフローの例

-

業務フローの自動化(マルチエージェントの結合)

-

データ分析・レポーティング

-

AIアシスタントによるナレッジ検索・問いあわせ対応

-

開発業務の効率化(コードアシスタントの強化)

-

環境の準備

-

MCPサーバーの作成

-

サーバーの起動

-

クライアント側での接続設定

-

動作確認

-

課題

-

今後の展望

目次

-

MCP(Model Context Protocol)とは?

-

なぜMCPが必要なのか?

-

背景と目的

-

従来のAIモデルとの違い

-

ユニバーサルアクセスと柔軟性

-

安全で標準化された接続

-

再利用性と拡張

-

維持管理のたやすさ

-

アーキテクチャ概要

-

通信プロトコル

-

提供される機能種別

-

データフローの例

-

業務フローの自動化(マルチエージェントの結合)

-

データ分析・レポーティング

-

AIアシスタントによるナレッジ検索・問いあわせ対応

-

開発業務の効率化(コードアシスタントの強化)

-

環境の準備

-

MCPサーバーの作成

-

サーバーの起動

-

クライアント側での接続設定

-

動作確認

-

課題

-

今後の展望

出典:Github

MCP(Model Context Protocol)とは?

MCP(Model Context Protocol)とは?

MCP(Model Context Protocol)は、 AIモデルが外部のツールやデータと連携するための標準的なプロトコル です。

従来、AIモデルを拡張するには個別にAPIを組み込んだり、カスタム開発を行ったりする必要がありました。しかし、MCPは 「統一された方法でAIモデルとツールを接続する」 ことを目的としており、開発者の負担を大幅に軽減します。

なぜMCPが必要なのか?

最近のAIは、単なるチャットボットから 「ツールを活用しながらタスクをこなす知的アシスタント」 へと進化しています。たとえば、

-

AIがスプレッドシートにデータを入力

-

AIが外部のニュースサイトから情報を取得

-

AIがスケジュールを管理して、会議の招待を送る

こういった機能をスムーズに実現するために、 MCPが「橋渡し役」 となるのです。

背景と目的

従来、AIに外部データへアクセスさせるにはM×N問題がありました。すなわち、M個のAIアプリケーションごとにN種類のデータソース連携を実装する必要があり、膨大な組み合わせのカスタム開発が発生していました。

結果として

-

「あるAIツールでは特定データだけ参照できるが他は不可」

-

「各社が似た連携機能を非互換な方法で実装」

-

「一つの改良が他には波及しない」

といった断片化が生じていました。

MCPが目指すのは、こうした状況をUSB-Cのような統一規格で打破することです。LLMとデータソースを繋ぐ標準インタフェースを定めることで、個別対応の複雑さを解消し、開発者はMCPさえ実装すれば多様なデータにアクセス可能になるというメリットをもたらします。

従来のAIモデルとの違い

それでは、従来のAIモデルとMCPを活用したAIの違いを見てみてましょう。

| 従来のAIモデル | MCPを活用したAI |

| 限られたデータのみで動作 | 外部のツール・データと連携可能 |

| APIの個別設定が必要 | MCPで統一的に接続 |

| AIが静的な情報しか扱えない | リアルタイムなデータ利用が可能 |

MCPを活用することで、上記問題を解消できそうですね。

MCPの導入によるメリット

.png?width=1662&height=1860&name=_-%20visual%20selection%20(2).png)

MCPを導入することで、次のようなメリットが生まれます。

ユニバーサルアクセスと柔軟性

単一のオープンプロトコルを介して、LLM(MCPクライアント)は任意の外部データソースに対してデータ取得やクエリを行えます。MCPは特定のベンダーに依存しない標準仕様のため、LLMのプロバイダを変更したり複数のAIを切り替える場合でも同じコネクタを再利用できます。

まさに「AI用の共通ポート」として機能し、環境やベンダーが異なってもシームレスに接続可能です。

安全で標準化された接続

MCPは認証やアクセス制御、データ形式の標準化をプロトコル内で扱うため、従来のようにデータソースごとにバラバラな認証方式やAPI形式に対応する必要がありません。

企業内データを自社インフラ内に留めたままAIに提供できる設計になっており(オンプレミス環境でMCPサーバーを立てられる)、ポリシーの適用や利用ログの一元管理も容易です。

この統一された接続はセキュリティとコンプライアンス面で大きな利点をもたらします。

再利用性と拡張

MCPではデータ連携部分を「コネクタ(サーバー)」というモジュールに切り出すため、開発者は一度コネクタを作れば複数のLLMやクライアントで再利用できます。

これにより「同じAPI連携を用途ごとに何度も作り直す」といった無駄を削減できます。

またオープンソースのコネクタが増えれば、必要な機能を組み合わせるだけで新しい統合を実現でき、エコシステム全体での効率向上につながります。

維持管理の容易さ

標準化されたアプローチにより、長期的なメンテナンス性が向上します。

従来のアドホックな統合は、新しいデータ源が増えるたびにコードの複雑化やバグ発生のリスクがありました。

MCPであれば共通仕様上で動くため連携部分の不具合が少なく、デバッグも統一的に行えます。

新たなプラットフォームを採用する際も既存のMCPコネクタを利用するか共有ライブラリに貢献すればよく、一から統合コードを書き直す必要が減ります。

MCPの技術的な仕組み

アーキテクチャ概要

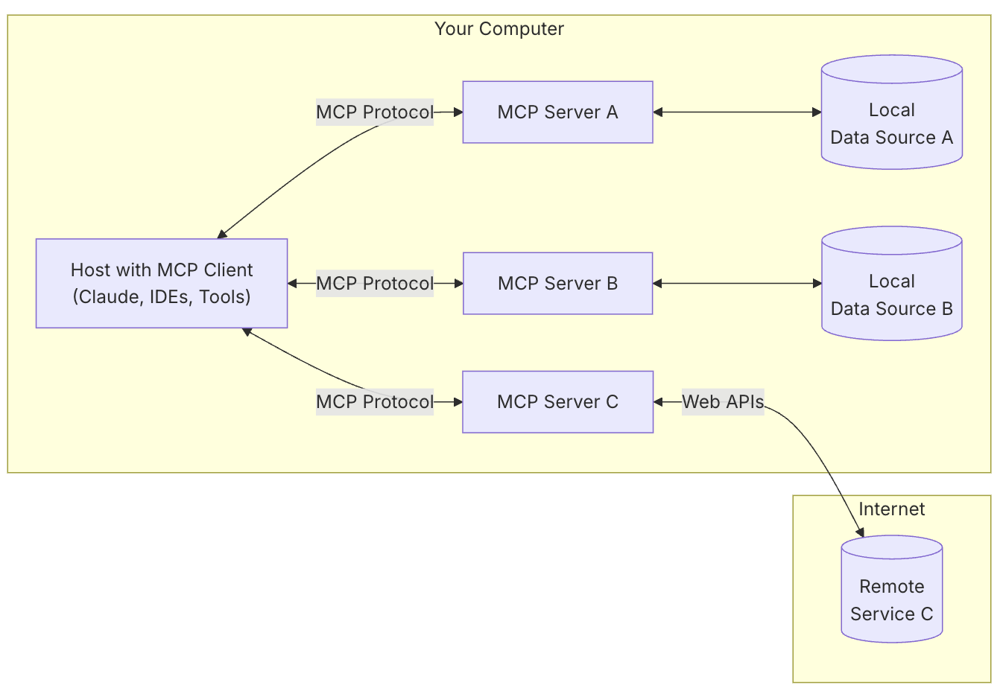

MCPはクライアント-サーバー型のアーキテクチャに基づいています。

(アーキテクチャ=システムやソフトウェア、ネットワークの全体的な構造、その設計方法)

MCPクライアント=AIが動いているアプリ側に組み込まれる部分(例:AIチャットアプリやIDE拡張など)

MCPサーバー=データソース(社内DBやWeb APIなど)に接続し、必要な情報を提供する小さなプログラム

この構造はプログラミング言語の開発環境で広く使われるLanguage Server Protocol (LSP)と類似しており、各LLMアプリケーション(MCPクライアント)がMCPサーバー群に接続する形で動作します。

具体的には、ホスト (Host) となるAIアシスタントアプリケーション(例: Claude DesktopやIDE拡張など)の内部にMCPクライアントが組み込まれ、必要に応じて外部のMCPサーバーに接続します。各MCPサーバーは企業のデータベースやクラウドAPIなど特定のデータソースや機能を公開する軽量なプログラムであり、ホストは複数のサーバーと同時に接続してデータをやり取りできます。

この構成により、AIアシスタント側は標準化された方法で様々な情報源へアクセス可能になるのです。

上述のMCPアーキテクチャ図では、ローカル環境上のAIアシスタント(ホスト)が複数のMCPサーバー(A,B,C)に接続し、それぞれが異なるデータソースに橋渡ししている様子が示されています。

例えばMCPサーバーA・Bはローカルのファイルやデータベースなどに接続し、MCPサーバーCはWebの外部サービス(API)にアクセスしています。ホスト側から見ると、これら複数のデータ源に対してすべてMCP経由の統一した方法で問い合わせや操作を行えるため、個別のAPI呼び出し方法の違いを意識する必要がありません。

通信プロトコル

(プロトコル=コンピュータでデータをやりとりするために定められた手順や規約などを定めた規格)

MCPクライアントとサーバーの通信にはJSON-RPC 2.0規約に従ったメッセージが使われます。

出典:JSON-RPC

クライアントはサーバーに対しJSON形式のリクエストを送り、サーバーはそれに対応するJSONレスポンスを返すという形で双方向のやりとりが行われます。

通信路(トランスポート)としては、ローカル環境であれば、標準入出力(stdin/stdout)パイプを用いた接続が典型で、リモート環境ならば、HTTPによるサーバー送信イベント(SSE)やWebSocket、UNIXドメインソケットなど複数のトランスポート方式に対応しています。

接続時にはまずクライアントからサーバーへinitializeメッセージを送り、自分の対応するプロトコルバージョンや能力を通知します。サーバー側もそれに応じて初期化応答を返し、以降どの機能をサポートしているかをクライアントとサーバー間で握手(ネゴシエーション)します。

提供される機能種別

MCPが扱う「コンテキスト(文脈情報)」は、大きく次の3種類に分類されます。

ツール (Tools)

LLMから呼び出せる関数や操作です。

例えばcreateNewTicket(チケット発行)や

uapdateDatabaseEntry(DB更新)といったアクションがツールに該当します。ツールはAIに計算や外部システムとのやりとりといったテキスト生成だけでは困難な操作を実行する能力を与えます。リソース (Resources)

ファイルやデータといった参照用の情報を指します。

例えば社内WikiのMarkdown文書「company_wiki.md」や財務データの表などがリソースとして提供されます。リソースはモデルに最新かつ詳細な知識を与える土台となり、汎用モデルをドメイン固有の有用なアシスタントへ変身させます。

プロンプト (Prompts)

あらかじめ用意されたテンプレート文章です。特定のタスクを行うようモデルを誘導する定型プロンプトや、フォーマット指定された指示文が該当します。プロンプトは一種のひな形としてモデルからの応答の品質や形式をコントロールする役割を果たします。

これらはいずれも最終的にはモデルのコンテキストウインドウ(入力テキスト空間)に埋め込まれる点で共通していますが、用途に応じて使い分けられます。

現在の実装では特にツール機能の利用が中心となっており、クライアント側もツール呼び出しを主体とした設計になっています。

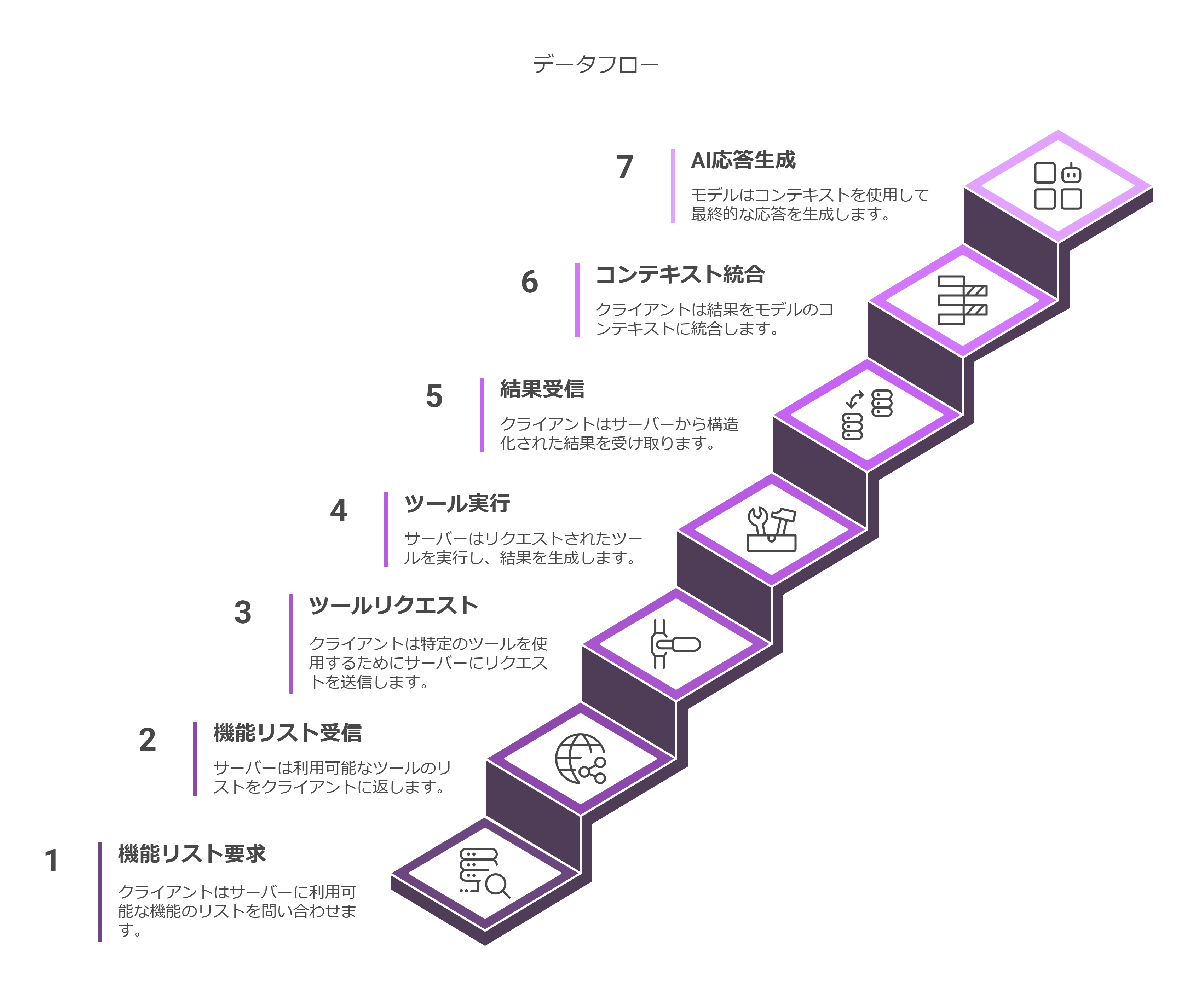

データフローの例

ポイント

- tools/listdeで利用可能なツール一覧を取得する

- tools/callで特定ツールを実行し、データを取得する

- 結果には "audience: assistant" などの注釈付きで返されるため、AIが適切に扱える

- クライアントは応答をコンテキストに組み込み、AIはそれを踏まえて回答生成

要するに、「AI→ツール呼び出し→結果取得→回答生成」がMCPによって標準化&自動化されている。

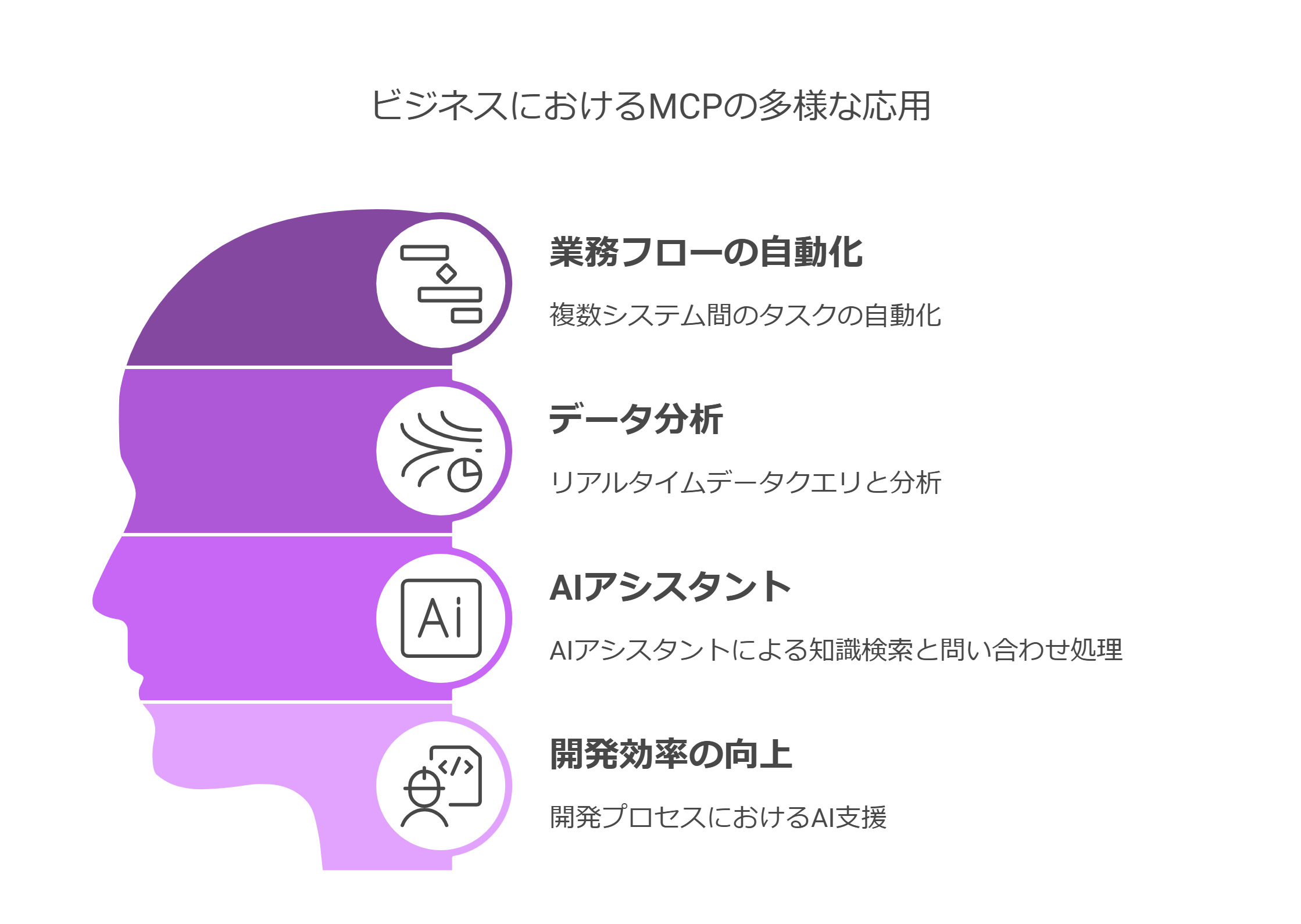

MCPの具体的なユースケース

MCPによって、LLMを企業の様々なシステムやデータと統合することが容易になるため、多彩なビジネス用途が考えられます。

既にBlock社やApollo社などは自社システムにMCPを統合し始めており、ZedやReplitといった開発支援ツールにもMCP連携が組み込まれつつあります。

以下にいくつか代表的なユースケース例を紹介します。

業務フローの自動化(マルチエージェント統合)

LLMが複数の社内システムに跨るタスクを自動遂行するシナリオです。

例えば、ある自動化エージェントがコード修正からチケット更新までを行うケースを考えてみます。

まずLLMがプログラミング課題に取り組む際、Gitリポジトリ用のMCPサーバーから変更された最新ファイル一覧(コンテキスト)を取得します。

次にチケット管理システムのMCPサーバーを呼び出し、対応するIssueを更新します。さらに完了報告を社内のチャットツール(Slack等)のMCPサーバー経由で投稿する、といった一連の処理を自律的に実行できます。

このようにMCPを軸に据えることで、複数ツール間の連携もすべて同じ手順で呼び出せるため、AIエージェントによる複雑な業務フロー自動化がシンプルになります。

データ分析・レポーティング

ビジネスにおけるデータ分析の場面でもMCPは活用できます。

LLMが企業内のデータベースやスプレッドシートに接続し、リアルタイムにクエリを実行したり分析結果を取得したりすることが可能です。

例えば売上データの集計や財務指標の計算を、ユーザーの質問に応じてAIが自動で行い、その結果をわかりやすく解説するといったことができます。MCPサーバーを読み取り専用の権限で設定しておけば、AIがデータを勝手に書き換えてしまうリスクを避けつつ安全に分析タスクを任せることができます。

これにより、専門知識がなくても経営陣がAIにデータ分析を問い合わせて迅速な意思決定に役立てる、といった応用も期待できます。

AIアシスタントによるナレッジ検索・問い合わせ対応

MCPは社内のナレッジベースやコミュニケーション履歴を横断的に活用するAIアシスタントの実現にも寄与します。

例えば、個人の知識メモ、企業内のSlackログ、課題管理システム、製品FAQデータベースといった複数の情報源をそれぞれMCPサーバーで繋ぎ込み、AIチャットボットがそれらを統合してユーザーからの質問に回答することができます。

これにより部署やシステムごとに分散していた情報のサイロを橋渡しし、人間の問い合わせに対して包括的で一貫性のある回答を引き出すことができます。

たとえばカスタマーサポートでは、チャットボットが顧客の問い合わせに対し、社内ドキュメントや過去の類似質問、製品データベースをすべて検索したうえで最適な解答を提示するといった支援が可能となります。

開発業務の効率化(コードアシスタントの強化)

MCPはソフトウェア開発の現場でも役立ちます。開発者向けAIアシスタントにリポジトリやドキュメントを読み込ませたり、タスク管理システムと連携させることで、より賢いコーディング支援が可能です。

例えば、AnthropicはClaudeを使ったプルリクエストレビュー支援サーバーのデモを公開しています。このMCPサーバーはGitHubからPRの詳細や差分を取得し(ツール呼び出し)、Claudeがコード変更点を解析して改善提案を生成し(プロンプト活用)、その結果をNotionドキュメントに自動保存する(別のツール呼び出し)という一連の流れを実現しています。

MCPによりコードレビューやドキュメント作成といった作業を自動化でき、開発者の生産性向上につながる好例と言えるでしょう。

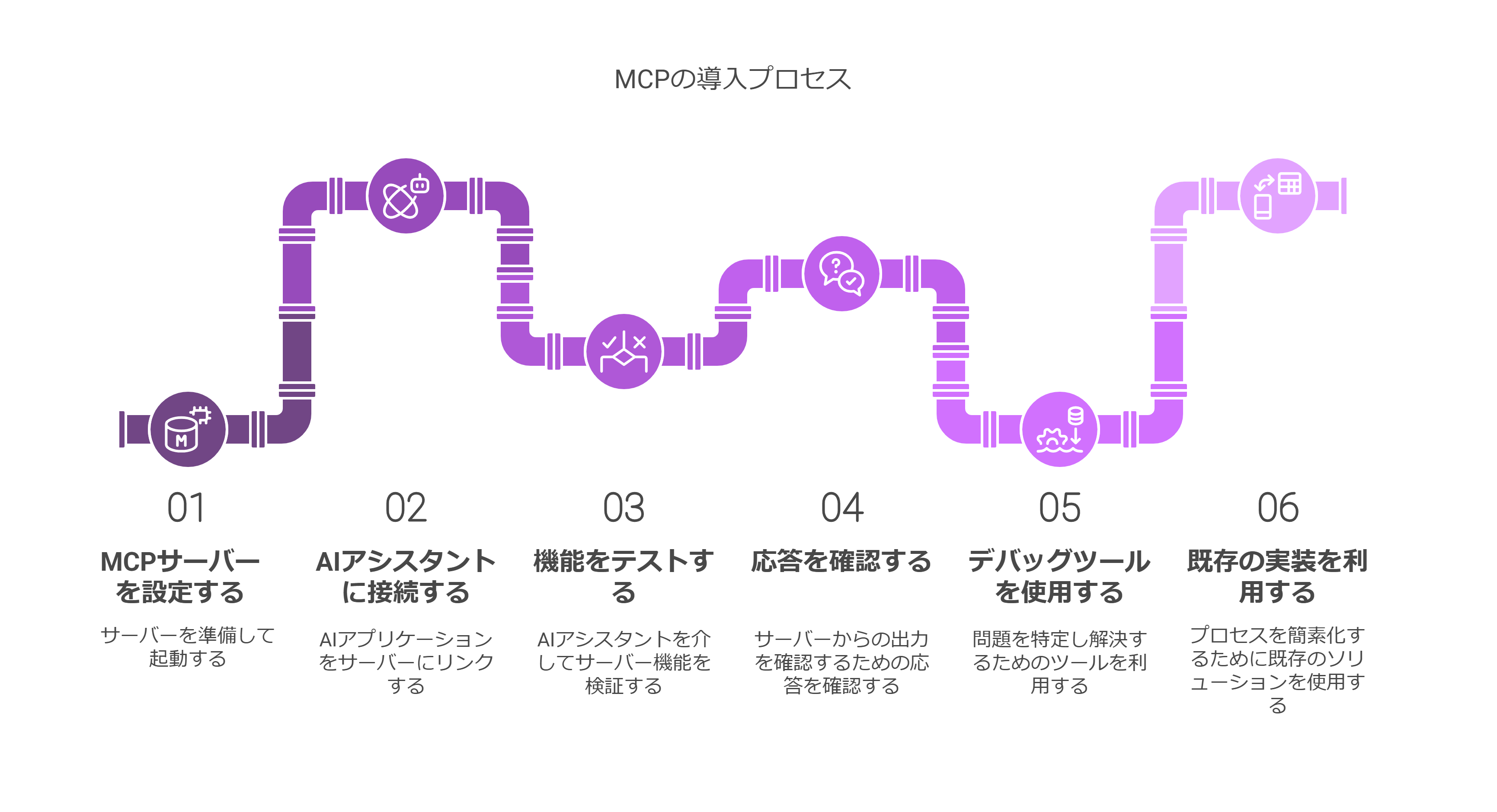

MCPの導入プロセス

1.環境の準備

開発に使用する言語環境を整えます。

例えばPythonで実装する場合、Python 3.10以上をインストールし、公式のMCPパッケージ(SDK)をpip経由で導入します。

pip install mcp[cli]のようにインストールすることで、MCPサーバー構築に必要なライブラリ一式が利用可能になります。Node.jsで実装する場合は、Node.js 20以上を用意し、npm経由でMCPフレームワークをインストールします(Anthropic提供のCLIツールも存在します)。

2.MCPサーバーの作成

対象とするデータソースや機能に合わせてMCPサーバーを実装します。

SDKを使うことで、サーバー名を指定してオブジェクトを生成し、関数デコレータなどで提供したいツールやリソースを定義できます。

以下はPython用SDK(FastMCP)を利用したシンプルなサーバー実装例です。天気情報を取得するツールを2つ公開するサーバーを定義しています(※簡潔さのためエラーハンドリング等は省略)。

上記の例では、FastMCPライブラリを用いて

weatherという名前のサーバーを作成し、2つのツール関数(get_alertsとget_forecast)を登録しています。それぞれHTTP APIから天気データを取得し、文字列として結果を返すシンプルな処理です。最後に

mcp.run(transport="stdio")を呼ぶことでサーバーの待受を開始します。このようにSDKを使えば、数十行のコードで自前のMCPコネクタ(サーバー)を実装可能です。3.サーバーの起動

実装したMCPサーバーを起動します。

先ほどのPythonコードであればターミナル上で

python weather_server.pyのように実行するだけで、標準入出力経由でクライアントからの接続を待ち受ける状態になります。MCPサーバーは起動時に自分の提供するツールやリソースのリストを内部で保持しており、クライアントから

tools/list等の要求があればそれに応答します。上記サーバーが正常に動いていれば、AI側からこのサーバー経由でget_alertsやget_forecastを呼び出せる準備が整ったことになります。4.クライアント側での接続設定

次にAIアシスタント(ホストアプリケーション)側で、起動したMCPサーバーに接続する設定を行います。

例えばClaude Desktopを利用している場合、設定ファイルやUI上で「カスタムMCPサーバー」として

weatherサーバーを登録します。Claude DesktopではMCPサーバーを検出すると自動でそのツールを会話に利用できるようになり、ユーザーが何もしなくてもAIがサーバー上のツールを認識して呼び出せる状態になります。ホストによって設定方法は異なりますが、基本的にはサーバーの所在(ローカル実行の場合は標準入出力かポート、リモートならURLなど)を指定して接続させるだけです。

MCP対応のホストにはClaudeの他にも、ZedエディタやCursorといった開発ツール、独自開発のチャットUIなどがあります。自作のクライアントを作る場合は、公式SDKのクライアントクラスを利用してサーバーとの接続処理を実装します。

5.動作確認

設定が完了したら、実際にAIアシスタントからMCPサーバー経由の機能が使えることを確認します。

Claude Desktopであればチャット画面で「今の気温は? (現在地の緯度経度を指定)」などと尋ねてみると、裏でモデルが

get_forecastツールを呼び出し、天気予報APIから取得した結果を含めて回答してくれるはずです。必要に応じてMCP Inspector等のデバッグツールを使うと、サーバーへのリクエスト内容や返答を確認でき、開発中の不具合検証に役立ちます。

MCPの課題・今後の展望

課題

魅力的なMCPですが、現時点ではいくつかの課題も認識されています。

エコシステムの成熟度

提唱から日が浅いため、利用できる既成のMCPサーバー(コネクタ)の種類や対応クライアントの数は発展途上です。

プロトコル自体の成熟

オープンソースプロジェクトとして開発が進められているため、今後フィードバックに応じて仕様変更や機能追加が行われる可能性があります。

セキュリティ面

MCPは安全な設計を志向していますが「AIが外部ツールを自由に使える」ことへの不安は依然残ります。最終的には導入企業側のポリシー設定と運用に委ねられる部分も大きく、MCPを適切に利用するためのルール作りが不可欠です。

モデル側の能力への依存

高度なLLMであればMCP経由で適切にツールを選択・活用できますが、モデルが十分に賢く文脈を理解できない場合、せっかく繋いだツール群を活用しきれない恐れもあります。

パフォーマンスやコストの問題

外部APIを逐次呼び出すため、応答時間が長くなったりAPI利用料が増えたりする可能性があります。

今後の展望

MCPは先駆的な取り組みであり、今後広く普及すればAI活用の様相を大きく変える可能性があります。将来像として考えられるポイントをいくつか挙げます。

業界標準としての定着

MCPが各社のAIプラットフォームやサービスでサポートされるようになれば、まさに「LLM界のUSBポート」として地位を確立するでしょう。主要なAPI提供企業が公式のMCPコネクタやドキュメントを公開し、API利用者はそれをインストールするだけでAI統合が可能、という流れも予想されます。

実際、API自動生成ツールのSpeakeasyはOpenAPI仕様からMCPサーバーを自動生成する試みを始めています。近い将来、各種プラットフォームがRESTやGraphQLに加えてMCPエンドポイントを提供するのが当たり前になるかもしれません。

より高度なエージェントの台頭

MCPによりデータアクセスが体系化され安全性も担保されれば、AIエージェントにより大きな裁量を与えることが可能になります。現在は人間が逐次確認しているツール実行も、将来的には信頼できる範囲で自律的に任せられるケースが増えるでしょう。

統合ガバナンスの確立

多数のAIとデータが繋がる世界では、統一された監査ログ管理とポリシー適用が重要になります。MCPは全てのデータアクセスやツール利用を一元的に記録できるため、企業は複数の異なるログを突き合わせる必要なくコンプライアンス対応が可能です。金融・医療など規制産業でも、MCP経由であればポリシー違反の検知や権限管理を中央集権的に行えるため、安心してAI活用を拡大できると期待されます。このようにセキュリティと利便性の両立を図れる点も、MCP普及の追い風となるでしょう。

開発コストの大幅削減

エコシステムが成熟し主要なコネクタが出揃えば、AI統合に要する開発コストは劇的に下がります。新しいツール導入時にも、まずMCP対応が提供されているかを確認し、あればそのコネクタを入れるだけで済む、といった世界です。

自前で統合を組まなくても必要な部品が揃っている状態になれば、AI活用のスピードも上がり、中小企業や個人開発者でも高度なAIシステムを構築しやすくなります。MCPはオープンソースコミュニティによっても支えられているため、みんなで整備した基盤を誰もが活用できるという好循環が生まれるでしょう。

まとめ

Model Context Protocolは「断片化した統合の接着剤」から「標準化された基盤」へのシフトを象徴する技術です。

AIアシスタントが当たり前に外界のデータを引き出し、判断し、行動する未来において、MCPは欠かせない役割を担うかもしれません。

まだ発展途上とはいえ、現時点でMCPに触れておくことは、文脈を理解し活用する次世代AIを見据えた先行投資と言えるでしょう。

ぜひMCPを活用し、「必要なデータが常にAIのすぐ手の届くところにある」世界を先取りしてみてください。

トピック:

AIナレッジ

おすすめ

関連ナレッジ

Lovableとは?“言葉だけ”で本格Webアプリを最速リリースできるAI開発プラットフォームのすべて

Lovableとは?“言葉だけ”で本格Webアプリを最速リリースできるAI開発プラットフォームのすべて

25/04/22 16:46

3

分で読了

プロンプトとは?読むだけでわかる!今こそ押さえたい「プロンプト」の基本

プロンプトとは?読むだけでわかる!今こそ押さえたい「プロンプト」の基本

25/04/08 2:57

2

分で読了

Supabaseとは?Firebase代替のオープンソースBaaSを徹底解説

Supabaseとは?Firebase代替のオープンソースBaaSを徹底解説

25/04/23 17:57

4

分で読了

.png?width=1080&height=169&name=logo-searcheleven-black%20(1).png)